In de afgelopen jaren hebben de computerdiensten in de public cloud zich voor het uitrollen van applicaties bewezen als zeer betrouwbaar en gemakkelijk op te schalen zonder complex systeembeheer. De voordelen van lage infrastructurele kosten en dus operationele besparingen deden IT-organisatie besluiten hun aandacht te richten op het migreren van applicaties naar de public cloud. Maar nu ze deze eenmaal massaal hebben omarmd, ervaren diezelfde organisaties ook de beperkingen.

Het economische voordeel van de cloud komt bij lang niet alle toepassingen uit de verf. Transactie-intensieve toepassingen bijvoorbeeld vereisen veel prestaties van de systeembronnen en onderliggende hardware van de clouddienst. Daarvoor moet de afnemer flink in de buidel tasten. Zoveel zelfs, dat het soms loont om de applicatie terug te brengen naar een on-premise omgeving met een infrastructuur in eigen beheer. Een hybride cloud is in zo’n geval voor bedrijven een uitkomst, omdat ze voor verschillende applicaties een ander soort infrastructuur kunnen kiezen.

Snoepwinkel met IT

Op papier lijkt de keuze voor de public cloud heel logisch. CIO’s wanen zich in een ’snoepwinkel’ vol panklare IT-faciliteiten van uiteenlopende smaken waaruit ze naar hartenlust hun favorieten selecteren. De drie dominerende marktpartijen: Google; Amazon; Microsoft, beconcurreren elkaar stevig op het gebied van generieke oplossingen, ontwikkelplatforms en infrastructuur. Selecteren en implementeren vergt geen weken of zelfs geen maanden meer. Het is een kwestie van handig shoppen en op het juiste moment bij het juiste aanbod toehappen, net als handelen op een beursvloer. Zeker ontwikkelaars hebben baat bij het gemak waarmee ze de cloud applicaties kunnen inrichten en uitrollen. De voorzieningen sluiten goed aan op hun agile werkwijze. Financiële managers geven de voorkeur aan de lage variabele kosten boven de kapitaalkosten vooraf bij gebruik van een traditionele infrastructuur. In het tijdperk van de public cloud lijkt het budget beheersbaar binnen de aanwezige toekomstplannen van de IT-omgeving.

Maar wat als de plannen tussentijds wijzigen? Kun je plotsklaps een gegarandeerde hoeveelheid I/O capaciteit bedingen, omdat een bepaalde applicatie onverwacht heel populair blijkt? En is het mogelijk om tussendoor data ergens anders te plaatsen, bijvoorbeeld vanwege wet- en regelgeving of omdat de eindgebruikers daarom vragen. In onze data en prestatie gedreven samenleving moeten we in staat zijn snel en flexibel te reageren op onverwachte zakelijke mogelijkheden. Wie denkt met de public cloud qua wendbaarheid goed te zitten, houdt geen rekening met het feit dat het generieke karakter van de cloud dienst (on-size-fits-all) geen ruimte biedt om zonder kostenconsequenties de IT-capaciteit volledig af te stemmen op de specifieke uitdagingen van jouw business.

Terug naar on-premise

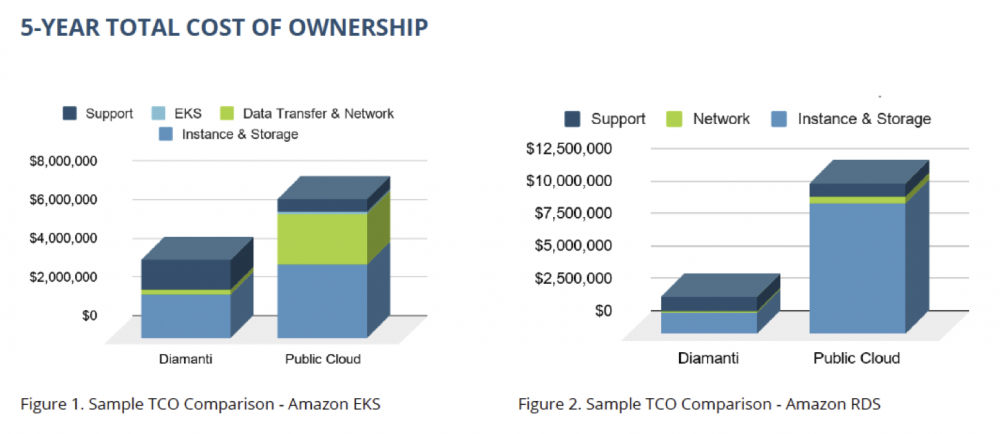

Twee jaar geleden gaven in een IDC-marktonderzoek naar cloud- en AI-acceptatie, zo’n 80 procent van de vierhonderd ondervraagde IT-beslissers aan dat zij omwille van de operationele wendbaarheid applicaties en data uit de public cloud hadden teruggebracht naar hun on-premise installaties. IT-managers kunnen de toekomst niet voorspellen en beschikken zelden over ongelimiteerde budgetten. Het is hun taak innovatieve systemen te introduceren die de zakelijke doeleinden van de onderneming ondersteunen. Zij willen niet leven met de permanente angst van uit de hand lopende kosten voor de voorzieningen van de public cloud. Total cost of ownership is een geschikte graadmeter om de investeringen in infrastructuur te beoordelen. De TCO-maat biedt organisaties een instrument om te evalueren en inzicht te krijgen in de werkelijke kosten en de onvoorziene uitgaven van de infrastructuur, zowel vooraf als tijdens de operationele uitvoering, aangevuld met een vergelijking tot in details van de belangrijkste public cloud opties.

IOPS voor snelle dataopslag

Welke elementen in de public cloud gaan het TCO-cijfer het meest beïnvloeden? Volgens mij zijn dat: de dataopslag-architectuur; de onverwachte netwerkkosten; de faciliteiten voor het repliceren van data. Om met het eerste elementen te beginnen, stellen we vast dat niet alle opgeslagen data evenveel waarde behoeft te vertegenwoordigen. Voor de bedrijfsprocessen kunnen er gradaties bestaan, die het nodig maken om aan bepaalde opslagvolumes meer aandacht te schenken dan aan anderen. We maken een keuze tussen de voorhanden opslagmedia met hun verschillende snelheden: harde schijven (HDD), solid state (SDD) of storage area networks (SAN). Meer IOPS (Input/Output Operaties per Seconde) omdat de applicaties (databases en ’boot’ volumes) daarom vragen, laat zich in de public cloud faciliteren via Provisioned IOPS. Maar die voorziening komt niet gratis. De meerkosten van de gekozen opslagarchitectuur beïnvloeden in dit geval de TCO aanzienlijk.

Hoge tol voor korte ritjes

Met het overbrengen van data naar de public cloud zijn doorgaans geen kosten gemoeid. Het schuiven met data binnen de public cloud, of naar buiten, kan de afnemer van de clouddienst het gevoel geven van een autorit op korte stukjes tolweg met veel tolpoorten. De tolafdracht lijkt telkens niet hoog, maar na heel veel constante ritjes, gaan de kosten toch merkbaar oplopen. Over de netwerkarchitectuur moet goed worden nagedacht. Is er een scheiding aangebracht tussen het deel van de software dat het opvragen van data afhandelt (data planes) en het deel dat het dataverkeer beheert (control plane)? Laat men die taken volledig over aan de cloud hosting faciliteiten, dan zijn ze als extra’s terug te vinden op de maandelijkse nota. Intensief overleg tussen financiële medewerkers en netwerkspecialisten moet uitwijzen welke vormen van dataoverdracht de kosten onverwacht laten oplopen. Die laatste groep zet je liever aan het werk om een reductie te bewerkstelligen in tijd en complexiteit van het netwerkverkeer op het moment dat applicaties naar de productieomgeving worden uitgerold.

Dubbele database instances

Wie applicaties, gevat in containers (microservices) via een public cloud aanbieder wil laten functioneren, moet zich realiseren dat bijvoorbeeld het toepassen van populaire Kubernetes-technologie samen met public cloud block-level storage voor hoofdbrekens kan zorgen. Dataverlies als gevolg van een falende zoneverwerking of database instance dan wel matig functionerende replicatievoorzieningen, zorgen voor boze eindgebruikers. De oplossing kan bestaan uit het dupliceren van databases en het beschikbaar stellen van read only database instances over verschillende verwerkingszones. Het replicatieproces verloopt via de database engine, waardoor de belasting op de centrale processor (CPU) en het geheugen verdubbelt en dus ook de kosten voor instances. In een TCO-meting pakt die kostenstijging ongunstig uit voor de public cloud.

Switchen van infrastructuur

Bedrijven die kozen voor een hybride cloud aanpak, kunnen - mits al hun applicaties cloud native zijn - gemakkelijk switchen tussen de infrastructuur van een public cloud aanbieder en de door hen zelf of door een derde partij beheerde on-premise omgeving. Met het Diamanti platform beschikken ze dan over een pasklare hybride cloud Kubernetes-oplossing die volledig is toegespitst op prestaties en efficiency. Hiermee laten waardevolle cloud native applicaties zich eenvoudig en snel uitrollen voor een aanzienlijk lagere TCO. Het platform is ontwikkeld als hyperconverged infrastructuur (HCI), waarin traditionele hardware functies zijn vertaald naar software. Om onnodige ’overhead’ van virtualisatie te voorkomen, is gekozen voor een ’bare-metal’ benadering, dus aansturing van containers rechtstreeks op de onderste laag van het Linux besturingssysteem op standaard X86 servers.

Vermijd verassende kosten

Het platform maakt Provisioned IOPS van public cloud providers overbodig. Door het toepassen van het NVMe protocol (Non-Volatile Memory express) krijgt elke werklast voldoende capaciteit en snelheid (IOPS) toegewezen op de nieuwste generatie SSD-geheugen. Dat is ondergebracht in een cluster met 10G ethernet-verbinding tussen de Diamanti-nodes. Aan elk daarvan wordt door de storage controller van de appliance op dynamisch wijze een interface (SR-IOV VF) toegewezen naar de geactiveerde applicaties. Elk virtueel geheugenvolume presenteert zich als een NVMe storage block.

Onaangename verassingen vanwege onverwachte hoge netwerkkosten blijven achterwege. Het Diamanti platform sluit naadloos aan op de gangbare datacenternetwerken. Daarmee komen Layer 2 interfaces beschikbaar voor alle containers. De overgang naar de containerstructuur wordt daarmee een stuk simpeler. De netwerkarchitectuur scheidt het beheer (control planes) van de 10G SR-IOV-data planes. Het applicatieverkeer is op hardware niveau volledig geïsoleerd van het host netwerk en andere container-netwerken. De processen delen dus nooit een kopie van de netwerk-stack met z’n eigen routering en firewall regels.

De gedistribueerde block storage faciliteiten van Diamanti ondersteunen een reeks van data-dupliceerfuncties zoals: snapshots; synchrone en asynchrone replicatie; lees/schrijf clones die efficiënt met de voorhanden opslagruimte omgaan; optimalisatie van data-opslag op SAN; datacompressie. Deze functies stellen IT-organisaties in staat controle uit te oefenen op het I/O-verkeer en op de infrastructuur waarop applicaties draaien. De prestaties overtreffen ruimschoots het niveau van die van gedupliceerde public cloud databases.

Soepel terug naar public cloud

Met behulp van binnen de IT-industrie geaccepteerde standaard interface-technologie verlaagt het Diamanti-platform de belasting van netwerk-, storage- en CPU/GPU-voorzieningen van de host configuratie on-premise en in de cloud. Wie heeft gekozen voor een hybride cloud architectuur, zal op enig moment afhankelijk van de economische voordelen vanuit on-premise terug willen naar de public cloud. Ook daarvoor levert Diamanti de beheer- en orkestratiefunctionaliteit voor applicaties gevat in zowel Kubernetes als in containers onder Docker Runtime. Het Spektra 2.4 platform is leverbaar met Ultima I/O acceleratie plug-in kaarten, geschikt voor een brede reeks moderne hyperconverged hardware. Onverwachte, explosieve groei van ’stateful’ Kubernetes-toepassingen vormt niet langer een probleem dankzij de ingebouwde Container Networking Interface (CNI) en de ingebouwde Container Storage Interface (CSI). Met functies als volume encryptie en ’self-encryption drives’ (SED) laten moderne applicaties zich beter beveiligen met geïntegreerde encryptie van zowel data in beweging als opgeslagen data zonder de prestaties te beïnvloeden en zonder consequenties voor de totale ’footprint’ van een datacenter. Door het toepassen van asynchrone replicatie kunnen bedrijven herstelprocessen ’offsite’ activeren terwijl hun data versleuteld blijven ten behoeve van gedistribueerde applicaties.

Erikjan Franssen is Vice-President EMEA bij Diamanti Inc.

29 en 30 oktober 2025 Deze 2-daagse cursus is ontworpen om dataprofessionals te voorzien van de kennis en praktische vaardigheden die nodig zijn om Knowledge Graphs en Large Language Models (LLM's) te integreren in hun workflows voor datamodel...

3 t/m 5 november 2025Praktische workshop met internationaal gerenommeerde spreker Alec Sharp over het modelleren met Entity-Relationship vanuit business perspectief. De workshop wordt ondersteund met praktijkvoorbeelden en duidelijke, herbruikbare ri...

17 t/m 19 november 2025 De DAMA DMBoK2 beschrijft 11 disciplines van Data Management, waarbij Data Governance centraal staat. De Certified Data Management Professional (CDMP) certificatie biedt een traject voor het inleidende niveau (Associate) tot...

25 en 26 november 2025 Worstelt u met de implementatie van data governance of de afstemming tussen teams? Deze baanbrekende workshop introduceert de Data Governance Sprint - een efficiënte, gestructureerde aanpak om uw initiatieven op het...

26 november 2025 Workshop met BPM-specialist Christian Gijsels over AI-Gedreven Business Analyse met ChatGPT. Kunstmatige Intelligentie, ongetwijfeld een van de meest baanbrekende technologieën tot nu toe, opent nieuwe deuren voor analisten met ...

8 t/m 10 juni 2026Praktische driedaagse workshop met internationaal gerenommeerde spreker Alec Sharp over herkennen, beschrijven en ontwerpen van business processen. De workshop wordt ondersteund met praktijkvoorbeelden en duidelijke, herbruikbare ri...

Alleen als In-house beschikbaarWorkshop met BPM-specialist Christian Gijsels over business analyse, modelleren en simuleren met de nieuwste release van Sparx Systems' Enterprise Architect, versie 16.Intensieve cursus waarin de belangrijkste basisfunc...

Deel dit bericht